Para hoy martes tenemos una entrada de Rafa García, amigo y antiguo colaborador de S2 Grupo que ya ha participado en el blog en alguna ocasión.

Para hoy martes tenemos una entrada de Rafa García, amigo y antiguo colaborador de S2 Grupo que ya ha participado en el blog en alguna ocasión.

Rafa ha dedicado los últimos años de su carrera profesional a la gestión de datacenters, campo en el que posee extensos conocimientos (como demuestra la presente entrada), y es actualmente Director de NIXVAL, un proveedor de servicios de externalización de centros de datos para alojamiento de sistemas de misión crítica, parte del grupo CLEOP. Esperemos que la entrada les guste tanto como a nosotros.

Recientemente, trabajando en una ampliación bastante importante de nuestro centro de datos he podido constatar ya de forma generalizada que el mercado propone parámetros de diseño de salas técnicas con temperatura ambiente de 25º C y control de humedad de humedad relativa al 80%. Este post va de porqué, cómo y hasta dónde pueden realizarse estos cambios en una sala técnica existente —en este caso una de un centro de datos real— ya que con estos nuevos parámetros de diseño los centros de datos han dejado de ser como los conocíamos hasta la fecha.

El aumento de la temperatura de la entrada en aire a los servidores de 21º hasta 25º es un cambio que está operativo desde hace aproximadamente 1 año en una de las salas de nuestro centro de datos, que alberga aproximadamente 130 kW de sistemas. ¿Porqué este aumento? Para ahorrar energía, claro. ¿Y no causa problemas en los sistemas? No. Los equipos actuales soportan temperaturas operativas de hasta 35º garantizadas por el fabricante. Como muestra los parámetros operativos del equipo DELL Poweredge R210, uno de los mas baratos (369 €) y populares servidores:

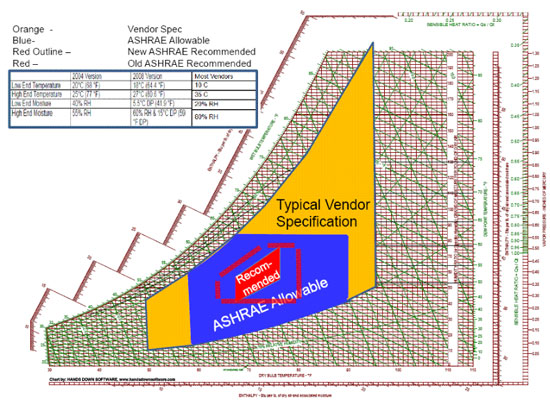

Debido a estas mayores prestaciones de los equipos y a los innovadores diseños de los nuevos centros de datos, ASHRAE, la asociación norteamericana de climatización —que son los que mandan— publicó un cambio del alcance de sus recomendaciones medioambientales, incrementándolas hasta 27º y 65% de humedad relativa. La zona azul en la carta psicrométrica es la autorizada por normativa y la amarilla la soportada por los equipos.

¿Y porqué 25º y no 35º directamente? Todos sabemos que los servidores aceleran como fórmulas 1 en cuanto la temperatura supera un cierto umbral. Los ventiladores se disparan y el consumo energético de los ventiladores aumenta de forma exponencial, pero ¿cuánto en relación al ahorro obtenido por el aumento de temperatura de la instalación? Los pocos estudios existentes al respecto (éste es de DELL y APC) recomiendan que la temperatura de entrada esté alrededor de los 25ºC, aunque este parámetro depende evidentemente de cada instalación. Nuestra decisión ha sido mantener estos 24º/25º, fundamentalmente por esa sensación de que no puede estar pasando nada bueno si en el CPD chirrían todos los servidores a la vez.

Con el aumento de la temperatura, el ahorro energético en la climatización en una sala diáfana con instalación de expansión directa es significativo en la teoría, pero presenta problemas operativos adicionales como las variaciones no homogéneas de la temperatura a lo largo de las filas de racks. La solución por la que hemos optado ha consistido en separar completamente el aire frío del caliente y contener los volúmenes a climatizar con contenedores de aluminio y policarbonato, tanto en los pasillos fríos como en las áreas de colocation dedicadas a clientes (en la foto). El resultado: el control exacto de la temperatura y la humedad relativa en los pasillos fríos y una mejora muy significativa en el rendimiento del sistema de climatización: el consumo del sistema de clima ha bajado un 32% en los meses de invierno.

Con el aumento de la temperatura, el ahorro energético en la climatización en una sala diáfana con instalación de expansión directa es significativo en la teoría, pero presenta problemas operativos adicionales como las variaciones no homogéneas de la temperatura a lo largo de las filas de racks. La solución por la que hemos optado ha consistido en separar completamente el aire frío del caliente y contener los volúmenes a climatizar con contenedores de aluminio y policarbonato, tanto en los pasillos fríos como en las áreas de colocation dedicadas a clientes (en la foto). El resultado: el control exacto de la temperatura y la humedad relativa en los pasillos fríos y una mejora muy significativa en el rendimiento del sistema de climatización: el consumo del sistema de clima ha bajado un 32% en los meses de invierno.

Uno de los efectos mas curiosos que pudimos observar inmediatamente tras la instalación de los contenedores y antes de aumentar la temperatura de la sala, fue que ante nuestra sorpresa, la temperatura de retorno del aire de la sala bajó 1,5ºC. ¿Bajó? ¡Si acabábamos de cerrar completamente las áreas del centro de datos en las que se introducía frío en el CPD! Pues sí, la temperatura bajó al utilizar los sistemas exclusivamente aire del contenedor, a una temperatura mucho más baja que el aire recalentado de la sala.

Con todo este trabajo hemos reducido costes e incrementado la capacidad: con la misma instalación somos capaces de soportar una carga IT mayor manteniendo la redundancia N+1. Pero el proceso no está exento de inconvenientes. El sistema de extinción de incendios ha tenido que adaptarse a las nuevas volumetrías compensando desde el suelo técnico las capacidades de inundación “perdidas” por los rociadores del techo y, por supuesto, el sistema de climatización ha tenido que recalibrarse para adaptarse al nuevo entorno.

Con todo este trabajo hemos reducido costes e incrementado la capacidad: con la misma instalación somos capaces de soportar una carga IT mayor manteniendo la redundancia N+1. Pero el proceso no está exento de inconvenientes. El sistema de extinción de incendios ha tenido que adaptarse a las nuevas volumetrías compensando desde el suelo técnico las capacidades de inundación “perdidas” por los rociadores del techo y, por supuesto, el sistema de climatización ha tenido que recalibrarse para adaptarse al nuevo entorno.

Por otra parte, el aumento de la temperatura en el pasillo frío sí ha tenido como consecuencia un aumento significativo de temperatura en los pasillos calientes y en el interior de los racks hasta 38º – 45º (dependiendo de cada rack). Esto ha afectado a instalaciones realizadas por clientes en la parte posterior de los bastidores —fundamentalmente de electrónica de red— que han tenido que ser reubicadas, y sobre todo a los equipos de red cuya entrada de aire es lateral y no frontal. Ojo, que los routers se paran si la temperatura de la CPU sube en exceso. Para ello ha sido necesario instalar dispositivos pasivos de recirculación lateral del aire como el de la figura que es del fabricante APC.

¿Y qué ha pasado con la humedad?… os lo cuento en el próximo capítulo.

Muy bueno Rafa