(A raíz de una desconcertante experiencia de la que he sido espectador esta mañana cuando esperaba en la cola del cajero para ingresar dinero, me ha parecido oportuno recuperar esta entrada, que fue uno de los primeros posts de este blog allá por mayo del 2007, que sin duda muchos de ustedes no habrán leído y los demás seguramente la habrán olvidado)

El pasado fin de semana estuve viendo por tercera o cuarta vez Casa de Juegos, de David Mamet; confieso que la recordaba mejor. Supongo que en cierto sentido, por eso el poeta cubano decía aquello de No vuelvas a los lugares donde fuiste feliz; nuestra memoria no siempre es fiel a la realidad. La película en cuestión es de hace ya veinte años, en la que Mike (Joe Mantegna) es un timador dispuesto a desvelarle los trucos y entresijos de su “oficio” a una psicóloga (Lindsay Crouse) demasiado curiosa.

En una de las escenas, ambos se acercan a una “tienda” de envío de dinero, se sientan y esperan al siguiente cliente. A los pocos segundos, un marine que tiene que volver a la base entra en el establecimiento. Justo en ese momento, Mike se acerca al dependiente y ostensiblemente se queja de que no hay noticias de su dinero, mientras el recién llegado observa la escena; en realidad, él no sabe que ese dinero no existe. Los siguientes minutos transcurren viendo cómo en una breve conversación el timador se gana la confianza de su víctima, lamentándose de su situación y comprometiéndose a que si su dinero llega antes que el del marine, le pagará el autobús para que pueda volver a la base. Finalmente, como era de esperar, el dinero del chico llega y éste se ofrece a darle parte de éste a Mike. Dinero a un desconocido a cambio de nada. ¿Qué hemos aprendido hoy?, le pregunta él a ella cuando salen del establecimiento (rechazando la oferta). A no fiarse de nadie, contesta él mismo.

No, no teman, no nos hemos convertido en un blog cinematográfico. Pero me pareció que esa escena es una buena forma de mostrar qué y cómo actúa a menudo la Ingeniería Social. Según Melissa Guenther, ésta puede definirse como «la adquisición de información sensible o accesos privilegiados por parte de terceros, a partir de la creación de falsas relaciones de confianza con personal interno de la organización», o en otras palabras, ¿porqué intentar forzar la puerta de atrás cuando pueden abrirte la principal desde dentro? Según esta autora, y para acabar, la ingeniería social se rige por los tres siguientes principios:

(1) El deseo de ser de ayuda,

(2) la tendencia a confiar en la gente, y

(3) el miedo a meterse en problemas (Le entiendo, pero si no me ayuda, voy a tener que dar parte a…).

No vamos a llegar hasta el punto de aconsejarles que, como suele decirse, no se fíen ni de su padre, ni es nuestra intención extender un estado de desconfianza entre las personas, pero por lo general, cuando se trate de temas de seguridad, desconfíen. Esa suele ser una buena política.

Con relativa frecuencia aparecen en prensa noticias sobre demandas judiciales entre empleados y empresas por violaciones deliberadas de la privacidad en el correo electrónico, pero poco se habla de los posibles problemas de privacidad que surgen fortuitamente durante el análisis que realizan los sistemas de detección de intrusos (IDS).

Con relativa frecuencia aparecen en prensa noticias sobre demandas judiciales entre empleados y empresas por violaciones deliberadas de la privacidad en el correo electrónico, pero poco se habla de los posibles problemas de privacidad que surgen fortuitamente durante el análisis que realizan los sistemas de detección de intrusos (IDS).  Llevo tiempo siguiendo este interesante blog, que se ha convertido en uno de mis favoritos y después de un tiempo queriendo aportar mi granito de arena, me he lanzado a la piscina y he preparado la siguiente colaboración que espero que les sea de agrado.

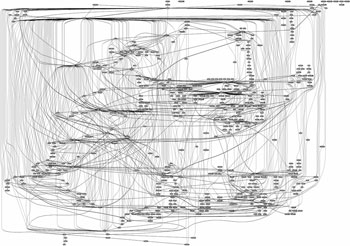

Llevo tiempo siguiendo este interesante blog, que se ha convertido en uno de mis favoritos y después de un tiempo queriendo aportar mi granito de arena, me he lanzado a la piscina y he preparado la siguiente colaboración que espero que les sea de agrado. Hace casi un año, el pasado 28 de Febrero de 2009 YouTube dejó de funcionar durante 2 horas. La incidencia —una incidencia de su conectividad— no se debió ni a la falta de redundancia de sus infraestructuras, ni a un fallo coordinado de todos sus proveedores, ni a un apagón simultáneo de todos sus centros de datos; ni siquiera al súbito interés simultáneo y mundial por el último vídeo de la Obama girl. YouTube dejó de funcionar debido al secuestro de parte de su direccionamiento IP por parte del operador Pakistan Telecom. ¿Secuestro? Sí, secuestro o suplantación del direccionamiento IP, algo tan antiguo como el propio protocolo BGP.

Hace casi un año, el pasado 28 de Febrero de 2009 YouTube dejó de funcionar durante 2 horas. La incidencia —una incidencia de su conectividad— no se debió ni a la falta de redundancia de sus infraestructuras, ni a un fallo coordinado de todos sus proveedores, ni a un apagón simultáneo de todos sus centros de datos; ni siquiera al súbito interés simultáneo y mundial por el último vídeo de la Obama girl. YouTube dejó de funcionar debido al secuestro de parte de su direccionamiento IP por parte del operador Pakistan Telecom. ¿Secuestro? Sí, secuestro o suplantación del direccionamiento IP, algo tan antiguo como el propio protocolo BGP.